Tecnología

Alarmantes denuncias de los empleados de OpenAI sobre la imprudente carrera por dominio absoluto

Un grupo de empleados de OpenAI está denunciando lo que consideran una cultura de imprudencia y secretismo en la empresa de inteligencia artificial de San Francisco, que se apresura a construir los sistemas de inteligencia artificial más potentes jamás creados.

El grupo, que incluye a nueve empleados y ex empleados de OpenAI, se ha reunido en los últimos días en torno a la preocupación compartida de que la empresa no ha hecho lo suficiente para evitar que sus sistemas de inteligencia artificial se vuelvan peligrosos.

Denuncias de los empleados de OpenAI

Los miembros afirman que OpenAI, que comenzó como un laboratorio de investigación sin ánimo de lucro y saltó a la luz pública con el lanzamiento en 2022 de ChatGPT, está dando prioridad a los beneficios y al crecimiento en su intento de crear inteligencia artificial general, o I.A.G., el término industrial para un programa informático capaz de hacer cualquier cosa que pueda hacer un humano.

También afirman que OpenAI ha utilizado tácticas de mano dura para evitar que los trabajadores expresen sus preocupaciones acerca de la tecnología, incluyendo acuerdos restrictivos de no desprestigio que se pidió firmar a los empleados salientes.

“OpenAI está realmente entusiasmada con la creación de la I.G.A., y están corriendo temerariamente para ser los primeros en ello”, dijo Daniel Kokotajlo, antiguo investigador de la división de gobernanza de OpenAI y uno de los organizadores del grupo.

Te puede interesar: Elon Musk confirma que desvió chips de Nvidia destinados a Tesla a sus compañías X y xAI

Pero nada ha calado tanto como la acusación de que OpenAI ha sido demasiado arrogante con la seguridad.

El mes pasado, dos investigadores de alto nivel –Ilya Sutskever y Jan Leike– abandonaron OpenAI bajo una nube de sospechas. El Dr. Sutskever, que había formado parte del consejo de OpenAI y votó a favor del despido del Sr. Altman, había hecho saltar las alarmas sobre los riesgos potenciales de los potentes sistemas de inteligencia artificial. Su marcha fue vista por algunos empleados preocupados por la seguridad como un revés.

También lo fue la marcha del Dr. Leike, que junto con el Dr. Sutskever había dirigido el equipo de «superalineación» de OpenAI, centrado en la gestión de los riesgos de los potentes modelos de inteligencia artificial. En una serie de mensajes públicos anunciando su marcha, el Dr. Leike dijo que creía que “la cultura y los procesos de seguridad han pasado a un segundo plano frente a los productos brillantes”.

Ni el Dr. Sutskever ni el Dr. Leike firmaron la carta abierta escrita por antiguos empleados. Pero sus salidas impulsaron a otros antiguos empleados de OpenAI a pronunciarse.

“Cuando me inscribí en OpenAI, no lo hice con esta actitud de ‘Vamos a poner las cosas en el mundo y ver qué pasa y arreglarlas después’”, dijo el Sr. Saunders.

Algunos de los antiguos empleados están vinculados al altruismo efectivo, un movimiento de inspiración utilitarista que en los últimos años se ha preocupado por prevenir las amenazas existenciales de la Inteligencia Artificial. Los críticos han acusado al movimiento de promover escenarios catastrofistas sobre la tecnología, como la idea de que un sistema de Inteligencia Artificial fuera de control podría tomar el poder y acabar con la humanidad.

Kokotajlo, de 31 años, se unió a OpenAI en 2022 como investigador de gobernanza y se le pidió que pronosticara el progreso de la inteligencia artificial. No era, por decirlo suavemente, optimista.

En su anterior trabajo en una organización de seguridad de la Inteligencia Artificial, predijo que la Inteligencia Artificial podría llegar en 2050. Pero después de ver lo rápido que mejoraba la I.A., acortó sus plazos. Ahora cree que hay un 50% de posibilidades de que la I.G.A. llegue en 2027, en sólo tres años.

También cree que la probabilidad de que la I.A. avanzada destruya o dañe catastróficamente a la humanidad -una sombría estadística a menudo abreviada como «p(doom)» en los círculos de I.A.- es del 70%.

En OpenAI, Kokotajlo vio que, aunque la empresa tenía protocolos de seguridad -incluido un esfuerzo conjunto con Microsoft conocido como “consejo de seguridad de despliegue”, que se suponía que revisaba los nuevos modelos en busca de riesgos importantes antes de que se hicieran públicos-, rara vez parecían frenar algo.

Con información de ACN / infobae

No dejes de leer: Capturado “influencer” colombiano que filmaba retos sexuales con estudiantes

Infórmate al instante únete a nuestro canal de Telegram NoticiasACN

Tecnología

ESET detecta un sitio falso que se hace pasar por la popular app CapCut para distribuir malware

La empresa de ciberseguridad ESET alertó sobre una campaña maliciosa que utiliza un sitio web falso para suplantar la identidad de la popular aplicación de edición de video CapCut, con el objetivo de distribuir malware a los usuarios.

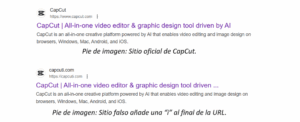

Según el reporte, el sitio fraudulento emplea una URL casi idéntica a la oficial, agregando una letra al final del dominio: www.capcuti.com en lugar de www.capcut.com.

Esta diferencia mínima puede pasar desapercibida para usuarios desprevenidos que buscan la app en Google o acceden a través de anuncios en redes sociales.

«Probablemente este sitio falso haya sido promovido a través de anuncios en los resultados de Google para intentar engañar a usuarios desprevenidos», explicó Camilo Gutiérrez Amaya, jefe del Laboratorio de Investigación de ESET Latinoamérica.

Además de la URL, los atacantes replicaron la estética del sitio oficial, lo que aumenta la credibilidad del engaño.

ESET también detectó que el certificado HTTPS del sitio falso es válido entre el 8 de abril y el 7 de julio de 2025, lo que sugiere la duración estimada de la campaña.

La advertencia se suma a otros casos recientes en los que cibercriminales aprovechan la popularidad de aplicaciones masivas como CapCut —que cuenta con más de 300 millones de usuarios activos mensuales— para distribuir software malicioso.

Con información de nota de prensa

Te invitamos a leer

“Hamlet” se prepara para conmover al público en la sala Rajatablade Caracas

Infórmate al instante únete a nuestros canales

WhatsApp ACN – Telegram NoticiasACN – Instagram acn.web – TikTok _agenciacn – X agenciacn

-

Carabobo20 horas ago

Carabobo20 horas agoVialsandi IAM reparó fuga de aguas blancas por tubería rota en el sector Los Jarales

-

Deportes13 horas ago

Deportes13 horas agoEl Bayern Múnich vence a Boca Juniors y avanza en el Mundial de Clubes

-

Deportes15 horas ago

Deportes15 horas agoDavid Martínez y Los Ángeles FC son eliminados del Mundial de Clubes

-

Carabobo15 horas ago

Carabobo15 horas agoAlcaldesa Dina Castillo inspeccionó el Terminal Big Low Center de Valencia